-

![[image]](https://www.balancer.ru/cache/sites/co/ib/ibb/i/9sRPLxN/128x128-crop/Screenshot-2023-04-18-19-16-07-887-org-telegram-messenger.png)

Нейросеть GPT-4

Какой толк от этой страшилки?Теги:

Sandro> Я полагаю, что в ближайшем времени ИИ мы не получим. А может быть, и вообще никогда. Ну по крайней мере, в том виде, как сейчас понимается ИИ — всезнающий интеллектуальный раб.

Что-либо в формате "Искусственное божество, ведущее к сингулярности человечества" - никогда.

Sandro> А вот Абсолютный Ассоциативный Словарь мы получить явно можем. Который на любой чих будет выдавать, что ему ведомо на эту тему. Но это будет словарь, а не интеллект.

Словарь всё-таки тема. Notion AI, из всех связанных с текстом AI-проектов пока самый внятный. ПО крайней мере из-за того, что всего лишь текстовый редактор со свистоперделками, а не "типа-заменитель поиска в гугле".

Для поисков в каком-нибудь PubChem/PubMed тоже что-нибудь этакое замутить, но не факт, что на LLM это будет легко и эффективно работать.

Что-либо в формате "Искусственное божество, ведущее к сингулярности человечества" - никогда.

Sandro> А вот Абсолютный Ассоциативный Словарь мы получить явно можем. Который на любой чих будет выдавать, что ему ведомо на эту тему. Но это будет словарь, а не интеллект.

Словарь всё-таки тема. Notion AI, из всех связанных с текстом AI-проектов пока самый внятный. ПО крайней мере из-за того, что всего лишь текстовый редактор со свистоперделками, а не "типа-заменитель поиска в гугле".

Для поисков в каком-нибудь PubChem/PubMed тоже что-нибудь этакое замутить, но не факт, что на LLM это будет легко и эффективно работать.

Татарин> От определения целевой функции зависит поведение сети, это банальность. Если принимающий при обучении сети работу человек халтурит, то он научит сеть плохому.

Банальность, а какими разными красками играет...

Татарин> Нормально человек должен полностью проверить корректность ответа.

Так большую часть проверок выполняет нейронка-оценщик...

В конце концов, OpenAI за 2$ нанимали кенийских эникейщиков для разметки промпта...

В конторах по программированию недаром существуют многоуровневые системы по проверке кода, DevOps'ы, Тимлиды, профильные специалисты (если речь идёт о написании какого-то ПО для своеобразной индустрии). Чай, не хэллоуворды люди пишут.

Татарин> Если же задачей стоИт просто удовлетворить человека, которому пофиг на ответ, то именно эта задача и будет решена.

Так в итоге эта, ИМЕННО ЭТА задача и решается. В конце концов, оценка кач-ва модели реализована тупо на модели лайков/дизлайков, большая часть которых вообще ботом расставлена.

Вон, Sandro по кирпичикам разобрал недокод.

Пока эта штука не захардкожена на "я не могу внятно отвечать на такие вопросы", она несёт бред с шансом 70%.

Банальность, а какими разными красками играет...

Татарин> Нормально человек должен полностью проверить корректность ответа.

Так большую часть проверок выполняет нейронка-оценщик...

В конце концов, OpenAI за 2$ нанимали кенийских эникейщиков для разметки промпта...

В конторах по программированию недаром существуют многоуровневые системы по проверке кода, DevOps'ы, Тимлиды, профильные специалисты (если речь идёт о написании какого-то ПО для своеобразной индустрии). Чай, не хэллоуворды люди пишут.

Татарин> Если же задачей стоИт просто удовлетворить человека, которому пофиг на ответ, то именно эта задача и будет решена.

Так в итоге эта, ИМЕННО ЭТА задача и решается. В конце концов, оценка кач-ва модели реализована тупо на модели лайков/дизлайков, большая часть которых вообще ботом расставлена.

Вон, Sandro по кирпичикам разобрал недокод.

Пока эта штука не захардкожена на "я не могу внятно отвечать на такие вопросы", она несёт бред с шансом 70%.

O.N.> Никто не пробовал установить? (что-то мне лень в виртуалке было .... на свой страх и риск ставлю...)

Это GPT4ALL, к GPT-4 от OpenAI оно отношения не имеет.

Это GPT4ALL, к GPT-4 от OpenAI оно отношения не имеет.

Татарин> Не получится по другой причине: НЯЗ, в публично доступной GPT-4 нет кода с дообучением учителем (или я его не увидел).

"Публично доступной" GPT-4 нет ВООБЩЕ. Все модели OpenAI уже много лет доступны лишь по платной подписке через API.

"Публично доступной" GPT-4 нет ВООБЩЕ. Все модели OpenAI уже много лет доступны лишь по платной подписке через API.

O.N.> То , что я не смогу её обучить - я уже понял .

Тебе с самого начала, с самых азов начать эту индустрию учить...

Посмотри на такой сайт, как Hugging Face - там много инструкций и очень удобных библиотек, и лит-ры по теме почитай, тебе тут накидают, если попросить.

Тебе с самого начала, с самых азов начать эту индустрию учить...

Посмотри на такой сайт, как Hugging Face - там много инструкций и очень удобных библиотек, и лит-ры по теме почитай, тебе тут накидают, если попросить.

Поначитался умных слов  , решил сам "поиграть" (благо проблем с доступом к "игрушке" сейчас нет).

, решил сам "поиграть" (благо проблем с доступом к "игрушке" сейчас нет).

Выбрал примитивную, всем понятную тему. Начал как бы с обычного поисковика

Этот ответ не интересен - поисковик тоже самое может выдать.

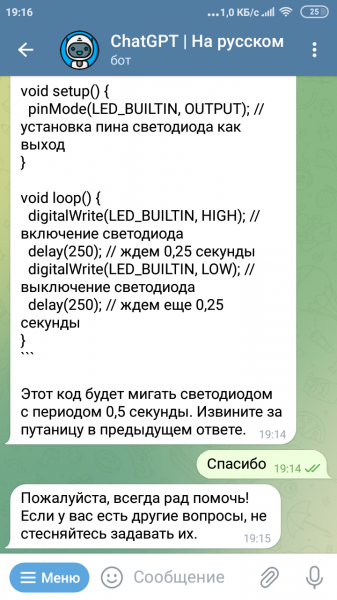

Чуть "подправил задачу":

этого варианта "готового" в интернете наверняка нет (да еще и с ошибкой).

Решил указать "собеседнику" на ляп с периодом.

Тут я проникся "уважением" к разработчикам

тем более, за извинение...

Очень интересная игрушка! Может помочь в работе - взять на себя рутину...

, решил сам "поиграть" (благо проблем с доступом к "игрушке" сейчас нет).

, решил сам "поиграть" (благо проблем с доступом к "игрушке" сейчас нет).Выбрал примитивную, всем понятную тему. Начал как бы с обычного поисковика

Этот ответ не интересен - поисковик тоже самое может выдать.

Чуть "подправил задачу":

этого варианта "готового" в интернете наверняка нет (да еще и с ошибкой).

Решил указать "собеседнику" на ляп с периодом.

Тут я проникся "уважением" к разработчикам

тем более, за извинение...

Очень интересная игрушка! Может помочь в работе - взять на себя рутину...

Nec

втянувшийся

Я на примере кода барометра BMP разочаровался в GPT. Ни тебе чтения калибровочных коэффициентов, ни температуры, от которой считается давление. Когда указываешь на ошибки, извиняется и пытается исправить. Но исправляет смесью на разных языках программирования)))

Nec> Когда указываешь на ошибки, извиняется и пытается исправить. Но исправляет смесью на разных языках программирования)))

О да! И делает это с абсолютной уверенностью).

О да! И делает это с абсолютной уверенностью).

Nec> Я на примере кода барометра BMP разочаровался в GPT.

...попробовал.

Вполне достойно

Правда я ограничил "поле деятельности" словом Arduino.

GPT быстро предложил типовой код: инициализация, опрос с выводом в монитор в цикле.

GPT предложил воспользоваться библиотеками от Adafruit. Предложил интерфейс I2C. Под него сделал скетч.

Ну, а библиотека написана один-в-один как в даташите на ВМР280.

GPT еще и "разукрасил скетч" - решил выводить результат в гектопаскалях

Так что первый результат - рабочий.

Затем я предложил ему определить апогей по данным барометра. Тут GPT явно схалтурил: в тот же цикл вывода данных ввел переменную Мах, в которую писал максимальное значение (по условию). На индикацию выводит текущее и максимальное значения. И ехидно текстом написал: "наблюдая за показаниями вы можете сделать вывод о достижении апогея - когда текущие показания будут слабо меняться, а их значение будет близко к максимальному".

Вполне считаю - достойно (если не считать весьма спорное определение им понятия апогей).

...попробовал.

Вполне достойно

Правда я ограничил "поле деятельности" словом Arduino.

GPT быстро предложил типовой код: инициализация, опрос с выводом в монитор в цикле.

GPT предложил воспользоваться библиотеками от Adafruit. Предложил интерфейс I2C. Под него сделал скетч.

Ну, а библиотека написана один-в-один как в даташите на ВМР280.

GPT еще и "разукрасил скетч" - решил выводить результат в гектопаскалях

Так что первый результат - рабочий.

Затем я предложил ему определить апогей по данным барометра. Тут GPT явно схалтурил: в тот же цикл вывода данных ввел переменную Мах, в которую писал максимальное значение (по условию). На индикацию выводит текущее и максимальное значения. И ехидно текстом написал: "наблюдая за показаниями вы можете сделать вывод о достижении апогея - когда текущие показания будут слабо меняться, а их значение будет близко к максимальному".

Вполне считаю - достойно (если не считать весьма спорное определение им понятия апогей).

Attacking LLM - Prompt Injection

How will the easy access to powerful APIs like GPT-4 affect the future of IT security? Keep in mind LLMs are new to this world and things will change fast. But I don't want to fall behind, so let's start exploring some thoughts on the security of LLMs. Get my font (advertisement): https://shop.liveoverflow.com Building the Everything API: https://www.youtube.com/watch?v=M2uH6HnodlM Injections Explained with Burgers: https://www.youtube.com/watch?v=WWJTsKaJT_g Chapters: 00:00 - Intro 00:41 - The OpenAI API 01:20 - Injection Attacks 02:09 - Prevent Injections with Escaping 03:14 - How do…

Прекрасное видео про нюансы систем...

Татарин> BTW, создататели StableDiffusion выкатили свою языковую модель, свободно доступную для скаяивания.

Угу, но пока она сырая (альфа). Но обещают релизы, обучение по методике RLHF, и размер как у GPT-3.

Если хочется поиграться с полностью открытыми нейронками с RLHF, Dolly-2 на базе GPT-6J Open Assistant на базе Pythia.

Недавно нашёл очень крутую опенсорсную тему, RKWV:

Крутой буст производительности, жаль, что эта система прошла незамеченной.

Угу, но пока она сырая (альфа). Но обещают релизы, обучение по методике RLHF, и размер как у GPT-3.

Если хочется поиграться с полностью открытыми нейронками с RLHF, Dolly-2 на базе GPT-6J Open Assistant на базе Pythia.

Недавно нашёл очень крутую опенсорсную тему, RKWV:

Raven RWKV 7B - a Hugging Face Space by BlinkDL

Discover amazing ML apps made by the community // huggingface.coКрутой буст производительности, жаль, что эта система прошла незамеченной.

Tayfur

втянувшийся

В.с.с.О.> Недавно нашёл очень крутую опенсорсную тему, RKWV:

В.с.с.О.> Raven RWKV 7B - a Hugging Face Space by BlinkDL

В.с.с.О.> Крутой буст производительности, жаль, что эта система прошла незамеченной.

Это ей на пользу. Может не прикроют и дадут вырасти. В моём представлении пусть лучше тема развивается в открытую чем закроют все кроме лишь некоторых.

В.с.с.О.> Raven RWKV 7B - a Hugging Face Space by BlinkDL

В.с.с.О.> Крутой буст производительности, жаль, что эта система прошла незамеченной.

Это ей на пользу. Может не прикроют и дадут вырасти. В моём представлении пусть лучше тема развивается в открытую чем закроют все кроме лишь некоторых.

Tayfur> Это ей на пользу. Может не прикроют и дадут вырасти. В моём представлении пусть лучше тема развивается в открытую чем закроют все кроме лишь некоторых.

Есть очень много Open Source проектов по этой теме. "Лавочку прикрывают" му**ки, которые просто охочие до денег.

Есть очень много Open Source проектов по этой теме. "Лавочку прикрывают" му**ки, которые просто охочие до денег.

apakhom> Выбрал примитивную, всем понятную тему. Начал как бы с обычного поисковика

У Гайвера есть видео, где он заставлял ГПТ (вроде 4-й версии) писать под ардуинку. Тот смог написать без задержек (delay), да ещё и сам придумал эффект для адресуемой светодиодной ленты.

Он ещё и сценарий умеет :) [показать]

У Гайвера есть видео, где он заставлял ГПТ (вроде 4-й версии) писать под ардуинку. Тот смог написать без задержек (delay), да ещё и сам придумал эффект для адресуемой светодиодной ленты.

Он ещё и сценарий умеет :) [показать]

Emergent Abilities of Large Language Models

Scaling up language models has been shown to predictably improve performance and sample efficiency on a wide range of downstream tasks. This paper instead discusses an unpredictable phenomenon that we refer to as emergent abilities of large language models. We consider an ability to be emergent if it is not present in smaller models but is present in larger models. Thus, emergent abilities cannot be predicted simply by extrapolating the performance of smaller models. The existence of such emergence implies that additional scaling could further expand the range of capabilities of language models. // arxiv.orgИсследование в тему.

В.с.с.О.> https://arxiv.org/abs/2206.07682

В.с.с.О.> Исследование в тему.

Скорее банальная констатация имеющихся фактов.

Собссно, как раз эмерджентные эффекты - то, что поражает. "Вау-эффект" для публики можно было бы создать и без этого, но вот "самостоятельно научившаяся" арифметике при чтении многих текстов языковая модель - это реально офигенно.

И если она может научиться арифметике, то почему, после чтения достаточного количества соотвествующих текстов, не может научиться дифференциальной геометрии? Или физике высоких энергий?

...и при этом - вот заметьте - никакого "самоосознания" и близко. Идеальный "усилитель интеллекта"©Лем. Не интеллектуальный раб, а палка-копалка как продолжение руки.

В.с.с.О.> Исследование в тему.

Скорее банальная констатация имеющихся фактов.

Собссно, как раз эмерджентные эффекты - то, что поражает. "Вау-эффект" для публики можно было бы создать и без этого, но вот "самостоятельно научившаяся" арифметике при чтении многих текстов языковая модель - это реально офигенно.

И если она может научиться арифметике, то почему, после чтения достаточного количества соотвествующих текстов, не может научиться дифференциальной геометрии? Или физике высоких энергий?

...и при этом - вот заметьте - никакого "самоосознания" и близко. Идеальный "усилитель интеллекта"©Лем. Не интеллектуальный раб, а палка-копалка как продолжение руки.

Татарин> Собссно, как раз эмерджентные эффекты - то, что поражает. "Вау-эффект" для публики можно было бы создать и без этого, но вот "самостоятельно научившаяся" арифметике при чтении многих текстов языковая модель - это реально офигенно.

Арифметика там чисто на базовом уровне. В математике они ошибаются и весьма ненадёжны.

Татарин> И если она может научиться арифметике, то почему, после чтения достаточного количества соотвествующих текстов, не может научиться дифференциальной геометрии? Или физике высоких энергий?

Вообще тут тупик, ИМХО. Пока есть нужда в сотнях гигабайт/терабайтах текстов, без гарантий удержания edge cases, далеко это штука не пойдёт.

Татарин> ...и при этом - вот заметьте - никакого "самоосознания" и близко. Идеальный "усилитель интеллекта"©Лем. Не интеллектуальный раб, а палка-копалка как продолжение руки.

ИМХО, как инструмент для креатива по мелочи, но в текущем виде политкорректной тряпки.

Арифметика там чисто на базовом уровне. В математике они ошибаются и весьма ненадёжны.

Татарин> И если она может научиться арифметике, то почему, после чтения достаточного количества соотвествующих текстов, не может научиться дифференциальной геометрии? Или физике высоких энергий?

Вообще тут тупик, ИМХО. Пока есть нужда в сотнях гигабайт/терабайтах текстов, без гарантий удержания edge cases, далеко это штука не пойдёт.

Татарин> ...и при этом - вот заметьте - никакого "самоосознания" и близко. Идеальный "усилитель интеллекта"©Лем. Не интеллектуальный раб, а палка-копалка как продолжение руки.

ИМХО, как инструмент для креатива по мелочи, но в текущем виде политкорректной тряпки.

Татарин>> Собссно, как раз эмерджентные эффекты - то, что поражает. "Вау-эффект" для публики можно было бы создать и без этого, но вот "самостоятельно научившаяся" арифметике при чтении многих текстов языковая модель - это реально офигенно.

В.с.с.О.> Арифметика там чисто на базовом уровне. В математике они ошибаются и весьма ненадёжны.

Большая разностная машина Бэббиджа вообще работать не могла. Тем не менее, "из искры возгорелось пламя".

Арифметика, особенно, если её учить на примерах - глубокая и очень абстрактная концепция.

Например, абсолютное большинство высших животных владеют (ессно, после всех усилий по обучению с достаточной мотивацией) ею либо никак, либо почти никак, и только в пределах сложения и вычитания (и даже с вычитанием сложности). С умножением и делением имеют большие проблемы даже шимпанзе, долго общающиеся с людьми, а сами люди осваивают концепт не ранее 4-5 лет (в большинстве).

По факту же, БЯМ никто не учил арифметике вообще. Она натаскалась на примерах текстов, и владеет ей весьма твёрдо. При том, что не обладает сознанием, вниманием и т.п. - "просто" рекуррентная сеть.

Чудо (эмерджентный эффект - всегда маленькое чудо ) не в том, что компутер может складывать числа, чудо в том, что эта способность появилась как результат изучения текстов.

) не в том, что компутер может складывать числа, чудо в том, что эта способность появилась как результат изучения текстов.

Татарин>> И если она может научиться арифметике, то почему, после чтения достаточного количества соотвествующих текстов, не может научиться дифференциальной геометрии? Или физике высоких энергий?

В.с.с.О.> Вообще тут тупик, ИМХО. Пока есть нужда в сотнях гигабайт/терабайтах текстов, без гарантий удержания edge cases, далеко это штука не пойдёт.

Очень уж "линейно" мыслите. Оно как бы было б да, если б развитием этих систем никто не занимался.

А ведь даже без Творца-Инженера мы знаем достаточно хороший путь к развитию таких систем.

Пишем конфигурацию сети как вектор, включаем генетический алгоритм, и начинаем классически-эволюционно скрещивать и отбирать лучшее.

В.с.с.О.> ИМХО, как инструмент для креатива по мелочи, но в текущем виде политкорректной тряпки.

Текущий вид вообще не имеет никакого значения и представляет только интерес только как пример. Ну и для истории.

В.с.с.О.> Арифметика там чисто на базовом уровне. В математике они ошибаются и весьма ненадёжны.

Большая разностная машина Бэббиджа вообще работать не могла. Тем не менее, "из искры возгорелось пламя".

Арифметика, особенно, если её учить на примерах - глубокая и очень абстрактная концепция.

Например, абсолютное большинство высших животных владеют (ессно, после всех усилий по обучению с достаточной мотивацией) ею либо никак, либо почти никак, и только в пределах сложения и вычитания (и даже с вычитанием сложности). С умножением и делением имеют большие проблемы даже шимпанзе, долго общающиеся с людьми, а сами люди осваивают концепт не ранее 4-5 лет (в большинстве).

По факту же, БЯМ никто не учил арифметике вообще. Она натаскалась на примерах текстов, и владеет ей весьма твёрдо. При том, что не обладает сознанием, вниманием и т.п. - "просто" рекуррентная сеть.

Чудо (эмерджентный эффект - всегда маленькое чудо

) не в том, что компутер может складывать числа, чудо в том, что эта способность появилась как результат изучения текстов.

) не в том, что компутер может складывать числа, чудо в том, что эта способность появилась как результат изучения текстов.Татарин>> И если она может научиться арифметике, то почему, после чтения достаточного количества соотвествующих текстов, не может научиться дифференциальной геометрии? Или физике высоких энергий?

В.с.с.О.> Вообще тут тупик, ИМХО. Пока есть нужда в сотнях гигабайт/терабайтах текстов, без гарантий удержания edge cases, далеко это штука не пойдёт.

Очень уж "линейно" мыслите. Оно как бы было б да, если б развитием этих систем никто не занимался.

А ведь даже без Творца-Инженера мы знаем достаточно хороший путь к развитию таких систем.

Пишем конфигурацию сети как вектор, включаем генетический алгоритм, и начинаем классически-эволюционно скрещивать и отбирать лучшее.

В.с.с.О.> ИМХО, как инструмент для креатива по мелочи, но в текущем виде политкорректной тряпки.

Текущий вид вообще не имеет никакого значения и представляет только интерес только как пример. Ну и для истории.

Fakir> Нормальное такое "рагу по-университетски" - вроде всё и сказано, обозрено, простите за выражение, сказано гладким языком (с изобилием штампов и общих фраз), только мысли нифига не видно

Fakir> Вывод: документ писал дурак, или халтурщик, или нейросеть - что в принципе почти равноценно.

Fakir> Школьные сочинения писать уже может. Курсовики и дипломы для второсортных вузов тоже. Статейки для провинциальных газет тоже. Ну тут, правда, придётся руками какой-нибудь дури добавлять, иначе не аутентично. Или примеры дури добавлять в базу ИИ.

Всегда набегают предшественники

И раскрыта главная тайна - ChatCGP уже два века, раньше просто скрывали

На минуточку, 1824, почти ровно 200 лет, а автора фиг угадаете [показать]

Fakir> Вывод: документ писал дурак, или халтурщик, или нейросеть - что в принципе почти равноценно.

Fakir> Школьные сочинения писать уже может. Курсовики и дипломы для второсортных вузов тоже. Статейки для провинциальных газет тоже. Ну тут, правда, придётся руками какой-нибудь дури добавлять, иначе не аутентично. Или примеры дури добавлять в базу ИИ.

Всегда набегают предшественники

Я увидел здесь две машины, вроде органов, с множеством колёс и цилиндров; они показались мне чрезвычайно многосложными: мой проводник растолковал мне их употребление. Это были: машина для делания стихов и машина для прозы. При мне сделано было несколько опытов, и я постараюсь моим читателям растолковать этот механизм, сколько я успел понять с первого взгляда.

Проводник мой выдвинул ящик, в котором находились маленькие четвероугольные косточки, наподобие употребляемых в игре домино: на них были написаны разные слова. Он, без всякого порядка, всыпал несколько пригоршней слов в ящик, под которым устроены были клавиши. После того уложил на шахматной доске рифмы, завёл машину — и пошла работа! Кузнечный мех, сжимаемый цилиндром, дул в ящик со словами, которые, побрякивая от действия ветра, выскакивали на шахматную доску в такт, под музыку. Чрез полчаса машина остановилась, и я прочёл стихи, в которых нашёл все слова на своём месте, меру, гармонию в стихах и богатые рифмы, — одним словом, всё, кроме здравого смысла и цели, точно так же, как в стихотворениях наших поэтов, которые страсть подбирать рифмы почитают вдохновением, а похвалу приятелей — достоинством.

Машина для делания прозы хотя устроена была точно таким же образом, но отличалась тем, что для определения тактов имела трубу и барабан, а не фортепьяно и что на косточках написаны были не одни только слова, но даже целые речения и мысли, выбранные из разных авторов.

— Нельзя ли сочинить что-нибудь на заданный предмет? — спросил я.

— Очень можно, — отвечал мой проводник, — что вам угодно?

Тут я хотел привести в затруднение проводника и доказать неудобство сочинительных машин. Я избрал предметом сочинения описание моей родины, любопытствуя, каким образом машина отделается от этой задачи и опишет место не виданное и, может быть, не слыханное ни одним из жителей полярных стран.

Проводник достал с полки словарь древней географии, отыскал в нём название моего отечественного города, подобрал написанные на косточках речения, сходные с книгой, взял принадлежащие к описанию собственные имена, множество прилагательных, несколько вспомогательных глаголов и кучу готовых речений, бросил всё это в ящик, пустил пружину, барабан ударил поход, труба заиграла марш, и косточки начали сыпаться.

Представьте себе моё удивление, когда чрез полчаса вышло довольно подробное описание города, в котором я родился. С первого взгляда показалось мне, что оно не уступает произведениям посредственных умов; но, прочитав со вниманием, я тотчас приметил напыщенность, пошлые изречения, чужие мысли и недостаток связи с целым, которые обнаруживали действие машины, а не ума.

— Весьма жаль, — сказал я, — что в наше время не знали этого изобретения; оно бы послужило в пользу весьма многим бесталанным головушкам.

— Оно было известно в ваше время, — отвечал мне проводник, — но сохранялось втайне между пишущей братией и переходило как наследственный секрет, от безграмотного к бестолковому и обратно. Впоследствии это изобретение усовершенствовано, а теперь вовсе не употребляется и хранится только для любопытных.

И раскрыта главная тайна - ChatCGP уже два века, раньше просто скрывали

На минуточку, 1824, почти ровно 200 лет, а автора фиг угадаете [показать]

Татарин> и в) нет особых оснований полагать, что мы стали сильно умнее за последние 100 лет, так что б тут могло (в лучшую сторону) изменить появление ИИ?

В среднем - однозначно не стали. Хотя вот IQ в среднем растёт - но то такое, очень частное и специфическое измерение ума. Но тем не менее рост есть. В т.ч. потому что люди навострились решать тесты некоторых видов, т.е. это частный случай освоения некоторых приёмов мышления.

А вот отдельные люди - как знать, как знать.

Приёмов же много, некоторые вполне эффективны, но кто ж ими пользуется? Подавляющее большинство людей о них и не подозревает. Простейшую диалектику (которая, как я недавно случайно понял, есть примитивный способ для не-шизоида хотя бы слегка приблизиться к шизоидному мышлению

) какой процент людей усвоил?

) какой процент людей усвоил?

Fakir>> Например, внезапно может оказаться, что характер зависимости "степени интеллектуальности" от числа нейронов имеет такой вид, что для достижения даже полноценного человеческого наших технических и экономических возможностей не хватит еще век или два, а "зачеловеческий" и вовсе уезжает на тыщу лет вправо.

Татарин> Да, это возможно, но... это было бы каким-то совершенно внезапным роялем из куста для нашей в целом бессердечной и не завязанной на человека реальности. Я бы очень, очень удивился, если б это было так исходя из чисто технических соображений:

Когда-то давно даже попадалось нечто подобное в журналах 80-х, что ли. Такой довольно впечатляющий трёхмерный график параметров "обрабатывающих информацию" систем, и мозг там находился буквально на границе. Откуда такое - я не понял.

Не могу ручаться за достоверность, но вот звучат мнения.

Татарин> Пример же с Колмогоровым... как раз то самое, что пугает. Колмогоров физически имел мозг практически на 100% схожий с нашим. Разница в интеллекте между нами и Колмогоровым (или Гарфильдом) определяется незначительной разницей в количестве и качестве нейронов, и по бОльшей части - обучением, конфигурацией сети.

Главная проблема, что мы НЕ ЗНАЕМ, в чём эта разница. Может, действительно только чуть-чуть чего-то не хватает, буквально вот еле-еле.

Может оказаться вообще всё, что угодно.

Например, какие-то очень большие со структурной точки зрения отличия в строении мозга - например, числа дендритов и/или длины. Или особенность биохимии нейронов. Или особенности строения. Или еще что-то Или сочетание вот это вот всего.

Татарин> Так вот искусственные нейросети очень быстро прошли путь от таракана до мыши и сейчас претендуют на уровень человека (неважно, что очень тупого человека, это вообще неважно на ТАКИХ масштабах). Ещё несколько шагов вперёд, и уже наше отличие с ними будет как у мыши с человеком.

Это МОЖЕТ быть, но никоим образом не гарантировано.

В среднем - однозначно не стали. Хотя вот IQ в среднем растёт - но то такое, очень частное и специфическое измерение ума. Но тем не менее рост есть. В т.ч. потому что люди навострились решать тесты некоторых видов, т.е. это частный случай освоения некоторых приёмов мышления.

А вот отдельные люди - как знать, как знать.

Приёмов же много, некоторые вполне эффективны, но кто ж ими пользуется? Подавляющее большинство людей о них и не подозревает. Простейшую диалектику (которая, как я недавно случайно понял, есть примитивный способ для не-шизоида хотя бы слегка приблизиться к шизоидному мышлению

) какой процент людей усвоил?

) какой процент людей усвоил?Fakir>> Например, внезапно может оказаться, что характер зависимости "степени интеллектуальности" от числа нейронов имеет такой вид, что для достижения даже полноценного человеческого наших технических и экономических возможностей не хватит еще век или два, а "зачеловеческий" и вовсе уезжает на тыщу лет вправо.

Татарин> Да, это возможно, но... это было бы каким-то совершенно внезапным роялем из куста для нашей в целом бессердечной и не завязанной на человека реальности. Я бы очень, очень удивился, если б это было так исходя из чисто технических соображений:

Когда-то давно даже попадалось нечто подобное в журналах 80-х, что ли. Такой довольно впечатляющий трёхмерный график параметров "обрабатывающих информацию" систем, и мозг там находился буквально на границе. Откуда такое - я не понял.

Не могу ручаться за достоверность, но вот звучат мнения.

Татарин> Пример же с Колмогоровым... как раз то самое, что пугает. Колмогоров физически имел мозг практически на 100% схожий с нашим. Разница в интеллекте между нами и Колмогоровым (или Гарфильдом) определяется незначительной разницей в количестве и качестве нейронов, и по бОльшей части - обучением, конфигурацией сети.

Главная проблема, что мы НЕ ЗНАЕМ, в чём эта разница. Может, действительно только чуть-чуть чего-то не хватает, буквально вот еле-еле.

Может оказаться вообще всё, что угодно.

Например, какие-то очень большие со структурной точки зрения отличия в строении мозга - например, числа дендритов и/или длины. Или особенность биохимии нейронов. Или особенности строения. Или еще что-то Или сочетание вот это вот всего.

Татарин> Так вот искусственные нейросети очень быстро прошли путь от таракана до мыши и сейчас претендуют на уровень человека (неважно, что очень тупого человека, это вообще неважно на ТАКИХ масштабах). Ещё несколько шагов вперёд, и уже наше отличие с ними будет как у мыши с человеком.

Это МОЖЕТ быть, но никоим образом не гарантировано.

Xan> Я, даже, не про ИИ, а про написание текстов с формулами для себя и для других.

Xan> Формулы в "компутерном" виде (и в ноутпаде, а не в ворде) гораздо полезнее, чем в хитро-жопо-мелом-на-доске.

Xan> Может, конечно, у меня профессиональное искажение психики!!!

"Борис, ты не прав" Ну то есть не всегда прав. Для каких-то случаев твой подход, конечно, правильный, иначе ты сам бы так не делал :), но для каких-то он вообще не годится.

Ну то есть не всегда прав. Для каких-то случаев твой подход, конечно, правильный, иначе ты сам бы так не делал :), но для каких-то он вообще не годится.

Например, если по формулам не цифирки считаешь, причём по относительно коротким, а делаешь длинные и громоздкие аналитические выкладки. С "компутерными" будут полные вилы. Даже мелом или на бумажке тоже через раз ж.па - тильду или штрих пропустил при переписывании куска выражения, и не заметил, даже пытаешься лапласиан перекроить к мало-мальски удобоваримому виду, и в итоге день работы насмарку, пачка бумаги в корзину. Стандартное было явление, бррр (причём у всех, только у старых и опытных теоретиков меньше времени уходило до того, как заметят - походу у них уже была бдительность на высоте и встроенный алгоритм постоянной самоперепроверки ). И это в нормальном рукописном виде, а что было бы в "контуперном" виде, хотя бы в Латеховском формате - да это ж подумать страшно!!! Там даже верстаючи уже написанную и выверенную формулу и то через раз было что-то не так.

). И это в нормальном рукописном виде, а что было бы в "контуперном" виде, хотя бы в Латеховском формате - да это ж подумать страшно!!! Там даже верстаючи уже написанную и выверенную формулу и то через раз было что-то не так.

Я когда таким занимался, очень упростил себе жизнь, когда обнаружил вордовский МатТайп - все эти многоярусные выкладки-перекомпоновки очень упростились, и почти совершенно исчезли досадные ошибки с "зевком" тильды. А потом встречал людей, которые совершенно независимо приходили к такой же методике работы - так что для некоторых видов выкладок её однозначно можно рекомендовать.

Xan> Формулы в "компутерном" виде (и в ноутпаде, а не в ворде) гораздо полезнее, чем в хитро-жопо-мелом-на-доске.

Xan> Может, конечно, у меня профессиональное искажение психики!!!

"Борис, ты не прав"

Ну то есть не всегда прав. Для каких-то случаев твой подход, конечно, правильный, иначе ты сам бы так не делал :), но для каких-то он вообще не годится.

Ну то есть не всегда прав. Для каких-то случаев твой подход, конечно, правильный, иначе ты сам бы так не делал :), но для каких-то он вообще не годится.Например, если по формулам не цифирки считаешь, причём по относительно коротким, а делаешь длинные и громоздкие аналитические выкладки. С "компутерными" будут полные вилы. Даже мелом или на бумажке тоже через раз ж.па - тильду или штрих пропустил при переписывании куска выражения, и не заметил, даже пытаешься лапласиан перекроить к мало-мальски удобоваримому виду, и в итоге день работы насмарку, пачка бумаги в корзину. Стандартное было явление, бррр (причём у всех, только у старых и опытных теоретиков меньше времени уходило до того, как заметят - походу у них уже была бдительность на высоте и встроенный алгоритм постоянной самоперепроверки

). И это в нормальном рукописном виде, а что было бы в "контуперном" виде, хотя бы в Латеховском формате - да это ж подумать страшно!!! Там даже верстаючи уже написанную и выверенную формулу и то через раз было что-то не так.

). И это в нормальном рукописном виде, а что было бы в "контуперном" виде, хотя бы в Латеховском формате - да это ж подумать страшно!!! Там даже верстаючи уже написанную и выверенную формулу и то через раз было что-то не так.Я когда таким занимался, очень упростил себе жизнь, когда обнаружил вордовский МатТайп - все эти многоярусные выкладки-перекомпоновки очень упростились, и почти совершенно исчезли досадные ошибки с "зевком" тильды. А потом встречал людей, которые совершенно независимо приходили к такой же методике работы - так что для некоторых видов выкладок её однозначно можно рекомендовать.

Fakir> В среднем - однозначно не стали. Хотя вот IQ в среднем растёт - но то такое, очень частное и специфическое измерение ума. Но тем не менее рост есть.

Ты читал Айзенка (который и ввёл это понятие)?

Во-первых, он, кажется, во первых строках своего писания попытался предостеречь от универсализации подхода, сразу подчёркивая, что это просто "ну хоть что-то вместо ничего", а потом эти предупреждения не раз повторял.

Во-вторых, фишечка методики в том, что Айзенк каким-то образом понял (вычислил, увидел, угадал) экспотенциальную зависимость скорости решения задач от их сложности. Выражающейся, конкретно в его тестах в размере потребной для решения задачи сверхоперативной памяти, которая у человека, как потом выяснили, что-то около 80 бит.

То есть, по мере подхода к границе задачи занимают всё бОльшее и бОльшее время, усложнение на 10% (например, добавлением к 10 имеющимся факторов, которые нужно учитывать одновременно, ещё одного фактора) удваивает-удесятеряет время решения задачи. Поэтому ты просто последовательно решаешь задачи на время, и в тот момент, когда ты подходишь к своему пределу, время на решение резко растёт и выходит за время, которое даётся тебе на тест. Берёшь номер задачи, за которой ты застрял надолго, и вот он, твой предел - плюс-минус где-то там.

Это я к тому, что вся шкала, для которой существует покрытие тестами, по сути, очень узкая, отличия в сложности задач относительно небольшие. Небольшие сдвиги по ней (да, достигаемые банальной тренировкой даже у одного человека - сам попробуй) ни-че-го не значат.

Потому что ты тренировкой ты не увеличиваешь свой ум, ты просто "хакаешь" методику, быстро решая задачи начального уровня, которые тебе "по уму". Даже если ты чуть вылезешь за свой предыдущий предел, ты всё равно уткнёшься в следующую задачу, где добавлен ещё один фактор, и их совокупность в итоге вылезет за пределы твоего пятна внимания.

Эти "улучшения" в мировом масштабе ровно ничего не значат, и лишь говорят о том, что в быте людей появилось больше схожих задач (или даже люди стали натаскивать себя на такие задачи с конкретной целью "повысить КИ" ).

).

...но главное тут то, что отличия дурака от гения тут просто таки совсем хорошо видны, и они - ну очень малы, если сравнивать известные нам системы (а не вариации одной человеческой).

Fakir> Приёмов же много, некоторые вполне эффективны, но кто ж ими пользуется? Подавляющее большинство людей о них и не подозревает. Простейшую диалектику (которая, как я недавно случайно понял, есть примитивный способ для не-шизоида хотя бы слегка приблизиться к шизоидному мышлению

) какой процент людей усвоил?

) какой процент людей усвоил?

Это было бы важно, если бы эти приёмы реально помогали бы решать сложные задачи, находить и рационализировать сложные паттерны, в общем случае.

А так - это просто ещё один паттерн в копилку, помогает увидеть что-то там, где иначе ты бы не видел ничего, но само по себе совершенно неважно.

Fakir>>> Например, внезапно может оказаться, что характер зависимости "степени интеллектуальности" от числа нейронов имеет такой вид,

Для биологических систем - да, это известно точно. У нас есть ограничения по физическим связям между нейронами - вот это белое вещество, которое сплошь провода, соединяющие нейроны с нейронами. Известно, что количество связей у умного человека и у дурака отличается на физическом уровне.

Но, например, у программной модели нет таких ограничений: при желании ты можешь связать все нейроны со всеми, и это само по себе тебе ничего не будет стоить, это лишь влияет на число параметров модели, а увеличение этого числа довольно дёшево.

170 миллиардов свободных параметров у ГПТ-4? Полтерабайта? Да легко.

Нужно 100Тб? или 1000Тб? Будет. Нефиг делать.

Даже на нынешнем технологическом уровне это вообще фигня, с учётом скорости работы нейронов (сотни Гц-кГц) сравнимую с мозгом производительность можно обеспечить даже размещая параметры модели на медленной (по компутерным меркам) памяти.

Высокая скорость работы нам нужна лишь на (нынешнем) этапе метаобучения. Когда мы, собссно, пытаемся понять, какие сетки лучше учатся и работают, нам важно сделать каждую попытку быстро, попробовать за

время на порядки меньшее, чем занимает обучение человека. Потом скорость работы будет уже гораздо менее важна: не важно, выдаст физик новую теорию через 1 секунду (как чатГПТ свой текст) или через 100, 10000 или даже через 1000000 секунд. Собссно, и 1000 000 000 секунд (~30 лет) - вполне приемлимое время, если речь идёт даже о слегка зачеловеческой задаче.

Мы-то её вообще не решим, вообще ни за какое время, разумное или нет.

Если же речь идёт о задачах в разы сложнее... сравни шимпанзе и человеком, а там разница именно невелика.

Fakir> Когда-то давно даже попадалось нечто подобное в журналах 80-х, что ли. Такой довольно впечатляющий трёхмерный график параметров "обрабатывающих информацию" систем, и мозг там находился буквально на границе. Откуда такое - я не понял.

Ну сам же понимаешь - что с чем они могли сравнивать-то? Мозг крутая штука - 1Е11 нейронов да на десятки-сотни Гц, да на количество аксонов, получаются нефиговые такие терафлопы, покруче, чем у современного телефона. Но именно что телефона, и именно что современного.

Ну сам же понимаешь - что с чем они могли сравнивать-то? Мозг крутая штука - 1Е11 нейронов да на десятки-сотни Гц, да на количество аксонов, получаются нефиговые такие терафлопы, покруче, чем у современного телефона. Но именно что телефона, и именно что современного.

Fakir> Главная проблема, что мы НЕ ЗНАЕМ, в чём эта разница. Может, действительно только чуть-чуть

Fakir> Например, какие-то очень большие со структурной точки зрения отличия в строении мозга - например, числа дендритов и/или длины. Или особенность биохимии нейронов. Или особенности строения. Или еще что-то Или сочетание вот это вот всего.

Знаешь, имея перед глазами пример, который вполне уверенно превзошёл в типичных "человеческих интеллектуальных" задачах шимпанзе и подобрался к уровню туповатого, но усердного человека...

...рассуждать о том, что что-то там в мозге есть очень особое уже поздновато.

Может, кстати, и есть, я легко допускаю. Я просто считаю это нерелевантным вопросу "может ли машина решать когнитивные задачи лучше, чем человек?". Явно может.

И симфонию сочинить, и портрет нарисовать, и в Старкрафт выиграть, и рабочий код написать, и подробную должностную инструкцию. Ну и какая разница в контексте, есть отличия на физическом уровне реализации или нет?

И калькулятор и эскаватор тоже сильно отличаются от человека, но считают и копают они лучше, и пофиг на остальное.

Fakir> Это МОЖЕТ быть, но никоим образом не гарантировано.

Скажем так: это ОЧЕНЬ МОЖЕТ быть.

И нужно быть очень большим пессимистом (ушедшим очень далеко от рационального), чтобы считать, что вот тут-то что-то и выскочит. Я бы понял эти сомнения до появления этих вот простеньких (если смотреть из будущего) демок - чатГПТ, МидДжорни, что там ещё... Но сейчас-то уже чего?

Ты читал Айзенка (который и ввёл это понятие)?

Во-первых, он, кажется, во первых строках своего писания попытался предостеречь от универсализации подхода, сразу подчёркивая, что это просто "ну хоть что-то вместо ничего", а потом эти предупреждения не раз повторял.

Во-вторых, фишечка методики в том, что Айзенк каким-то образом понял (вычислил, увидел, угадал) экспотенциальную зависимость скорости решения задач от их сложности. Выражающейся, конкретно в его тестах в размере потребной для решения задачи сверхоперативной памяти, которая у человека, как потом выяснили, что-то около 80 бит.

То есть, по мере подхода к границе задачи занимают всё бОльшее и бОльшее время, усложнение на 10% (например, добавлением к 10 имеющимся факторов, которые нужно учитывать одновременно, ещё одного фактора) удваивает-удесятеряет время решения задачи. Поэтому ты просто последовательно решаешь задачи на время, и в тот момент, когда ты подходишь к своему пределу, время на решение резко растёт и выходит за время, которое даётся тебе на тест. Берёшь номер задачи, за которой ты застрял надолго, и вот он, твой предел - плюс-минус где-то там.

Это я к тому, что вся шкала, для которой существует покрытие тестами, по сути, очень узкая, отличия в сложности задач относительно небольшие. Небольшие сдвиги по ней (да, достигаемые банальной тренировкой даже у одного человека - сам попробуй) ни-че-го не значат.

Потому что ты тренировкой ты не увеличиваешь свой ум, ты просто "хакаешь" методику, быстро решая задачи начального уровня, которые тебе "по уму". Даже если ты чуть вылезешь за свой предыдущий предел, ты всё равно уткнёшься в следующую задачу, где добавлен ещё один фактор, и их совокупность в итоге вылезет за пределы твоего пятна внимания.

Эти "улучшения" в мировом масштабе ровно ничего не значат, и лишь говорят о том, что в быте людей появилось больше схожих задач (или даже люди стали натаскивать себя на такие задачи с конкретной целью "повысить КИ"

).

)....но главное тут то, что отличия дурака от гения тут просто таки совсем хорошо видны, и они - ну очень малы, если сравнивать известные нам системы (а не вариации одной человеческой).

Fakir> Приёмов же много, некоторые вполне эффективны, но кто ж ими пользуется? Подавляющее большинство людей о них и не подозревает. Простейшую диалектику (которая, как я недавно случайно понял, есть примитивный способ для не-шизоида хотя бы слегка приблизиться к шизоидному мышлению

) какой процент людей усвоил?

) какой процент людей усвоил?Это было бы важно, если бы эти приёмы реально помогали бы решать сложные задачи, находить и рационализировать сложные паттерны, в общем случае.

А так - это просто ещё один паттерн в копилку, помогает увидеть что-то там, где иначе ты бы не видел ничего, но само по себе совершенно неважно.

Fakir>>> Например, внезапно может оказаться, что характер зависимости "степени интеллектуальности" от числа нейронов имеет такой вид,

Для биологических систем - да, это известно точно. У нас есть ограничения по физическим связям между нейронами - вот это белое вещество, которое сплошь провода, соединяющие нейроны с нейронами. Известно, что количество связей у умного человека и у дурака отличается на физическом уровне.

Но, например, у программной модели нет таких ограничений: при желании ты можешь связать все нейроны со всеми, и это само по себе тебе ничего не будет стоить, это лишь влияет на число параметров модели, а увеличение этого числа довольно дёшево.

170 миллиардов свободных параметров у ГПТ-4? Полтерабайта? Да легко.

Нужно 100Тб? или 1000Тб? Будет. Нефиг делать.

Даже на нынешнем технологическом уровне это вообще фигня, с учётом скорости работы нейронов (сотни Гц-кГц) сравнимую с мозгом производительность можно обеспечить даже размещая параметры модели на медленной (по компутерным меркам) памяти.

Высокая скорость работы нам нужна лишь на (нынешнем) этапе метаобучения. Когда мы, собссно, пытаемся понять, какие сетки лучше учатся и работают, нам важно сделать каждую попытку быстро, попробовать за

время на порядки меньшее, чем занимает обучение человека. Потом скорость работы будет уже гораздо менее важна: не важно, выдаст физик новую теорию через 1 секунду (как чатГПТ свой текст) или через 100, 10000 или даже через 1000000 секунд. Собссно, и 1000 000 000 секунд (~30 лет) - вполне приемлимое время, если речь идёт даже о слегка зачеловеческой задаче.

Мы-то её вообще не решим, вообще ни за какое время, разумное или нет.

Если же речь идёт о задачах в разы сложнее... сравни шимпанзе и человеком, а там разница именно невелика.

Fakir> Когда-то давно даже попадалось нечто подобное в журналах 80-х, что ли. Такой довольно впечатляющий трёхмерный график параметров "обрабатывающих информацию" систем, и мозг там находился буквально на границе. Откуда такое - я не понял.

Ну сам же понимаешь - что с чем они могли сравнивать-то? Мозг крутая штука - 1Е11 нейронов да на десятки-сотни Гц, да на количество аксонов, получаются нефиговые такие терафлопы, покруче, чем у современного телефона. Но именно что телефона, и именно что современного.

Ну сам же понимаешь - что с чем они могли сравнивать-то? Мозг крутая штука - 1Е11 нейронов да на десятки-сотни Гц, да на количество аксонов, получаются нефиговые такие терафлопы, покруче, чем у современного телефона. Но именно что телефона, и именно что современного.Fakir> Главная проблема, что мы НЕ ЗНАЕМ, в чём эта разница. Может, действительно только чуть-чуть

Fakir> Например, какие-то очень большие со структурной точки зрения отличия в строении мозга - например, числа дендритов и/или длины. Или особенность биохимии нейронов. Или особенности строения. Или еще что-то Или сочетание вот это вот всего.

Знаешь, имея перед глазами пример, который вполне уверенно превзошёл в типичных "человеческих интеллектуальных" задачах шимпанзе и подобрался к уровню туповатого, но усердного человека...

...рассуждать о том, что что-то там в мозге есть очень особое уже поздновато.

Может, кстати, и есть, я легко допускаю. Я просто считаю это нерелевантным вопросу "может ли машина решать когнитивные задачи лучше, чем человек?". Явно может.

И симфонию сочинить, и портрет нарисовать, и в Старкрафт выиграть, и рабочий код написать, и подробную должностную инструкцию. Ну и какая разница в контексте, есть отличия на физическом уровне реализации или нет?

И калькулятор и эскаватор тоже сильно отличаются от человека, но считают и копают они лучше, и пофиг на остальное.

Fakir> Это МОЖЕТ быть, но никоим образом не гарантировано.

Скажем так: это ОЧЕНЬ МОЖЕТ быть.

И нужно быть очень большим пессимистом (ушедшим очень далеко от рационального), чтобы считать, что вот тут-то что-то и выскочит. Я бы понял эти сомнения до появления этих вот простеньких (если смотреть из будущего) демок - чатГПТ, МидДжорни, что там ещё... Но сейчас-то уже чего?

Татарин> Эти "улучшения" в мировом масштабе ровно ничего не значат,

Конечно ничего принципиального не значат. Это просто пример, что некоторые, малозначительные, методы мышления всё же распространяются, люди их достаточно массово осваивают.

Татарин> Это было бы важно, если бы эти приёмы реально помогали бы решать сложные задачи, находить и рационализировать сложные паттерны, в общем случае.

Да вполне помогают. Логику зачем изучают? Хотя бы самую примитивную, аристотелеву. Что уж говорить о чём-то более изощрённом.

Татарин> А так - это просто ещё один паттерн в копилку, помогает увидеть что-то там, где иначе ты бы не видел ничего, но само по себе совершенно неважно.

Ну привет! Ты так договоришься до того, что пастух из дикой степи ничего не приобретает в мышлении от получения образования до докторантуры включительно

Татарин> Но, например, у программной модели нет таких ограничений: при желании ты можешь связать все нейроны со всеми, и это само по себе тебе ничего не будет стоить, это лишь влияет на число параметров модели, а увеличение этого числа довольно дёшево.

Мда? И это не заклинит твоё физическое вместилище этой матмодели?

Татарин> Потом скорость работы будет уже гораздо менее важна: не важно, выдаст физик новую теорию через 1 секунду (как чатГПТ свой текст) или через 100, 10000 или даже через 1000000 секунд. Собссно, и 1000 000 000 секунд (~30 лет) - вполне приемлимое время, если речь идёт даже о слегка зачеловеческой задаче.

Татарин> Мы-то её вообще не решим, вообще ни за какое время, разумное или нет.

Даже если - ЕСЛИ! - это так. Если времена действительно такие - а не, скажем, 1000 лет, а ведь х его з.

Казалось бы да, на решение такой задачки не грех потратить 30 лет.

Но.

Это ведь на решение.

А сколько уйдёт на обучение методам решения таких задачек? На отладку? Сдаётся мне, что в целом где-то как минимум на порядок больше времени, чем на собственно решение отлаженной неросеткой.

Что уже плаааавно так отодвигает практические приложения вправо почти на десятилетия-век.

Татарин> Ну сам же понимаешь - что с чем они могли сравнивать-то? Мозг крутая штука - 1Е11 нейронов да на десятки-сотни Гц, да на количество аксонов, получаются нефиговые такие терафлопы, покруче, чем у современного телефона. Но именно что телефона, и именно что современного.

Ну сам же понимаешь - что с чем они могли сравнивать-то? Мозг крутая штука - 1Е11 нейронов да на десятки-сотни Гц, да на количество аксонов, получаются нефиговые такие терафлопы, покруче, чем у современного телефона. Но именно что телефона, и именно что современного.

Там было утверждение, что якобы именно на грани принципиально возможного - не технически и на сейчас, а вообще.

Конечно, утверждение сильное и хз откуда взятое, может и бредовое. Но что видел.

Не знаю, может если вспомню, откуда это, то смогу раскопать график.

Татарин> Знаешь, имея перед глазами пример, который вполне уверенно превзошёл в типичных "человеческих интеллектуальных" задачах шимпанзе и подобрался к уровню туповатого, но усердного человека...

...в очень частных и специфических задачах.

Помнишь все как бы не 60-х гг разговоры и комментарии в научпопе, как мол фантасты неправильно представляют себе, что робота-домработницу сделать легче, чем пилота ракеты или шахматного гроссмейстера? И они таки да были правы.

Однако не впадаем ли мы сейчас в аналогичный грех, но только наоборот? Ну сумела нейросетка справляться с некоторыми типами задач. Исключительно символьно-словесного характера, да и то такого... без работы с формальной логикой. Но это не более чем один из минимум четырёх "типов ума" (логический, символьный, образный, моторный, эмоциональный), и то не в полном объёме. А минимум трёх у него нету в принципе. Сводимы ли они принципиально и технически к символьному? Может да, может, нет. Может принципиально сводимы, а технически вилы.

А "интеллект" без хотя бы трёх этих типов - это даже не калека.

Обезъянам и прочим слонособакам остро не хватает символьно-логического интеллекта, зато с моторным полный порядок, да и образный какой-никакой имеется (некоторые животные даже себя в зеркале узнают).

Кстати, вот вариант теста: если когда-нибудь специально не обучавшаяся на это нейросетка начнёт себя узнавать в зеркале

Татарин> Может, кстати, и есть, я легко допускаю. Я просто считаю это нерелевантным вопросу "может ли машина решать когнитивные задачи лучше, чем человек?". Явно может.

Татарин> И симфонию сочинить, и портрет нарисовать, и в Старкрафт выиграть, и рабочий код написать, и подробную должностную инструкцию.

Некоторые когнитивные задачи.

Так некоторые из перечисленных задач решаются вообще без следа интеллекта - задача написания симфонии решается при помощи игральных костей и специальной таблицы, больше двух веков как успешно решается, ну пусть не симфонии, а вальса, но вполне годного и оригинального.

С портретом отлично справляется фотоаппарат, а с добавлением фильтров даже не фотошопа, а ACDSee вообще супер.

И т.п.

А уж половина должностных инструкции вообще такое ощущение, что самозарождается в грязном белье, как мыши. А если не самозарождается там, так лучше бы самозарождалась.

Конечно ничего принципиального не значат. Это просто пример, что некоторые, малозначительные, методы мышления всё же распространяются, люди их достаточно массово осваивают.

Татарин> Это было бы важно, если бы эти приёмы реально помогали бы решать сложные задачи, находить и рационализировать сложные паттерны, в общем случае.

Да вполне помогают. Логику зачем изучают? Хотя бы самую примитивную, аристотелеву. Что уж говорить о чём-то более изощрённом.

Татарин> А так - это просто ещё один паттерн в копилку, помогает увидеть что-то там, где иначе ты бы не видел ничего, но само по себе совершенно неважно.

Ну привет! Ты так договоришься до того, что пастух из дикой степи ничего не приобретает в мышлении от получения образования до докторантуры включительно

Татарин> Но, например, у программной модели нет таких ограничений: при желании ты можешь связать все нейроны со всеми, и это само по себе тебе ничего не будет стоить, это лишь влияет на число параметров модели, а увеличение этого числа довольно дёшево.

Мда? И это не заклинит твоё физическое вместилище этой матмодели?

Татарин> Потом скорость работы будет уже гораздо менее важна: не важно, выдаст физик новую теорию через 1 секунду (как чатГПТ свой текст) или через 100, 10000 или даже через 1000000 секунд. Собссно, и 1000 000 000 секунд (~30 лет) - вполне приемлимое время, если речь идёт даже о слегка зачеловеческой задаче.

Татарин> Мы-то её вообще не решим, вообще ни за какое время, разумное или нет.

Даже если - ЕСЛИ! - это так. Если времена действительно такие - а не, скажем, 1000 лет, а ведь х его з.

Казалось бы да, на решение такой задачки не грех потратить 30 лет.

Но.

Это ведь на решение.

А сколько уйдёт на обучение методам решения таких задачек? На отладку? Сдаётся мне, что в целом где-то как минимум на порядок больше времени, чем на собственно решение отлаженной неросеткой.

Что уже плаааавно так отодвигает практические приложения вправо почти на десятилетия-век.

Татарин>

Ну сам же понимаешь - что с чем они могли сравнивать-то? Мозг крутая штука - 1Е11 нейронов да на десятки-сотни Гц, да на количество аксонов, получаются нефиговые такие терафлопы, покруче, чем у современного телефона. Но именно что телефона, и именно что современного.

Ну сам же понимаешь - что с чем они могли сравнивать-то? Мозг крутая штука - 1Е11 нейронов да на десятки-сотни Гц, да на количество аксонов, получаются нефиговые такие терафлопы, покруче, чем у современного телефона. Но именно что телефона, и именно что современного.Там было утверждение, что якобы именно на грани принципиально возможного - не технически и на сейчас, а вообще.

Конечно, утверждение сильное и хз откуда взятое, может и бредовое. Но что видел.

Не знаю, может если вспомню, откуда это, то смогу раскопать график.

Татарин> Знаешь, имея перед глазами пример, который вполне уверенно превзошёл в типичных "человеческих интеллектуальных" задачах шимпанзе и подобрался к уровню туповатого, но усердного человека...

...в очень частных и специфических задачах.

Помнишь все как бы не 60-х гг разговоры и комментарии в научпопе, как мол фантасты неправильно представляют себе, что робота-домработницу сделать легче, чем пилота ракеты или шахматного гроссмейстера? И они таки да были правы.

Однако не впадаем ли мы сейчас в аналогичный грех, но только наоборот? Ну сумела нейросетка справляться с некоторыми типами задач. Исключительно символьно-словесного характера, да и то такого... без работы с формальной логикой. Но это не более чем один из минимум четырёх "типов ума" (логический, символьный, образный, моторный, эмоциональный), и то не в полном объёме. А минимум трёх у него нету в принципе. Сводимы ли они принципиально и технически к символьному? Может да, может, нет. Может принципиально сводимы, а технически вилы.

А "интеллект" без хотя бы трёх этих типов - это даже не калека.

Обезъянам и прочим слонособакам остро не хватает символьно-логического интеллекта, зато с моторным полный порядок, да и образный какой-никакой имеется (некоторые животные даже себя в зеркале узнают).

Кстати, вот вариант теста: если когда-нибудь специально не обучавшаяся на это нейросетка начнёт себя узнавать в зеркале

Татарин> Может, кстати, и есть, я легко допускаю. Я просто считаю это нерелевантным вопросу "может ли машина решать когнитивные задачи лучше, чем человек?". Явно может.

Татарин> И симфонию сочинить, и портрет нарисовать, и в Старкрафт выиграть, и рабочий код написать, и подробную должностную инструкцию.

Некоторые когнитивные задачи.

Так некоторые из перечисленных задач решаются вообще без следа интеллекта - задача написания симфонии решается при помощи игральных костей и специальной таблицы, больше двух веков как успешно решается, ну пусть не симфонии, а вальса, но вполне годного и оригинального.

С портретом отлично справляется фотоаппарат, а с добавлением фильтров даже не фотошопа, а ACDSee вообще супер.

И т.п.

А уж половина должностных инструкции вообще такое ощущение, что самозарождается в грязном белье, как мыши. А если не самозарождается там, так лучше бы самозарождалась.

Татарин> И если она может научиться арифметике, то почему, после чтения достаточного количества соотвествующих текстов, не может научиться дифференциальной геометрии? Или физике высоких энергий?

Ну скажем, так. У нас есть пример в виде Wolfram Mathematica. Написанный человеком и реально решающий крайне сложные математические задачи.

А вот теперь вопрос: как долго надо мучить сетку, чтобы она была способна выдать подобное?

(подумав) ладно, задам совсем издевательский вопрос: как долго надо мучить сетку, чтобы она могла разложить любое число, меньше миллиона, на простые сомножители?

Ну скажем, так. У нас есть пример в виде Wolfram Mathematica. Написанный человеком и реально решающий крайне сложные математические задачи.

А вот теперь вопрос: как долго надо мучить сетку, чтобы она была способна выдать подобное?

(подумав) ладно, задам совсем издевательский вопрос: как долго надо мучить сетку, чтобы она могла разложить любое число, меньше миллиона, на простые сомножители?

Copyright © Balancer 1997..2023

Создано 29.03.2023

Связь с владельцами и администрацией сайта: anonisimov@gmail.com, rwasp1957@yandex.ru и admin@balancer.ru.

Создано 29.03.2023

Связь с владельцами и администрацией сайта: anonisimov@gmail.com, rwasp1957@yandex.ru и admin@balancer.ru.

Верный союзник с Окинавы

Верный союзник с Окинавы

инфо

инфо инструменты

инструменты apakhom

apakhom

Татарин

Татарин

AleksejLt

AleksejLt

Татарин

Татарин

Fakir

Fakir